一、Zookeeper介绍

ZooKeeper是一个分布式的,开放源码的分布式应用程序协调服务,是Google的Chubby一个开源的实现,是Hadoop和Hbase的重要组件。它是一个为分布式应用提供一致性服务的软件,是一个针对大型分布式系统的可靠协调系统;

目标就是封装好复杂易出错的关键职务,将简单易用的接口和性能高效、功能稳定的系统提供给用户;

Zookeeper已经成为Hadoop生态系统中的基础组件。

1、工作原理

ZooKeeper是以Fast Paxos算法为基础的,Paxos 算法存在活锁的问题,即当有多个proposer交错提交时,有可能互相排斥导致没有一个proposer能提交成功,而Fast Paxos作了一些优化,通过选举产生一个leader (领导者),只有leader才能提交proposer,具体算法可见Fast Paxos。因此,要想弄懂ZooKeeper首先得对Fast Paxos有所了解

2、ZooKeeper的基本运转流程

- 选举Leader。

- 同步数据。

- 选举Leader过程中算法有很多,但要达到的选举标准是一致的。

- Leader要具有最高的执行ID,类似root权限。

- 集群中大多数的机器得到响应并接受选出的Leader。

3、Zookeeper特点

最终一致性:为客户端展示同一视图,这是Zookeeper最重要的性能;

可靠性:如果消息被一台服务器接受,那么它将被所有的服务器接受;

4、Zookeeper应用场景

1)分布式环境下,经常需要对应用/服务进行统一命名,便于识别不同的服务

可将服务名称以及地址信息写在Zookeeper上,客户端通过Zookeeper获取可用服务列表。

一旦znode中的数据被修改,Zookeeper将会通知各个节点。

1)分布式环境下经常存在一个服务需要知道它所管理的子服务的状态

多个客户端同时在Zookeeper上创建相同znode,只有一个创建成功。

多个客户端同时在Zookeeper上创建相同znode,创建成功的那个客户端得到锁,其他客户端等待。

各个客户端在某个znode下创建临时znode(类型为CreateMode.EPHEMERAL_SEQUENTIAL),这样,该znode可掌握全局访问时序。

5、用到了Zookeeper的一些系统

二、Zookeeper集群安装部署

下面开始介绍Zookeeper的安装部署。安装部署分三种模式:单机模式、伪分布式模式和分布式模式。单机模式和伪分布式比较简单,多用于本地测试调试,下面介绍分布式模式安装部署。

注意:3台机器都需要安装zk。对于Zookeeper集群的话,官方推荐的最小节点数为3个。

| 操作系统 | IP地址 | 安装软件 |

| Centos 7.4 | 192.168.8.20 | JDK1.8、zookeeper-3.4.10 |

| Centos 7.4 | 192.168.8.21 | JDK1.8、zookeeper-3.4.10 |

| Centos 7.4 | 192.168.8.22 | JDK1.8、zookeeper-3.4.10 |

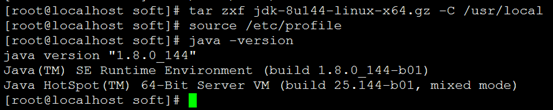

[root@localhost ~]# cd /data/soft

[root@localhost soft]# wget -c https://mirrors.yangxingzhen.com/jdk/jdk-8u144-linux-x64.tar.gz

[root@localhost soft]# tar zxf jdk-8u144-linux-x64.gz -C /usr/local

[root@localhost soft]# vim /etc/profile,添加以下内容

export JAVA_HOME=/usr/local/jdk1.8.0_144

export CLASSPATH=$CLASSPATH:$JAVA_HOME/lib:$JAVA_HOME/jre/lib

export PATH=$JAVA_HOME/bin:$JAVA_HOME/jre/bin:$PATH:$HOMR/bin

[root@localhost soft]# java -version

[root@localhost soft]# wget -c http://mirror.bit.edu.cn/apache/zookeeper/zookeeper-3.4.10/zookeeper-3.4.10.tar.gz

2、解压安装配置第一台zk

[root@localhost soft]# tar zxf zookeeper-3.4.10.tar.gz -C /usr/local/

[root@localhost soft]# cd /usr/local/zookeeper-3.4.10/

[root@localhost zookeeper-3.4.10]# mkdir -p dataDir

[root@localhost zookeeper-3.4.10]# mkdir -p datalogDir

【注意】:如果不配置dataLogDir,那么事务日志也会写在dataDir目录中。这样会严重影响zk的性能。因为在zk吞吐量很高的时候,产生的事务日志和快照日志太多。

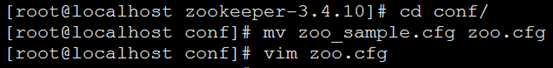

[root@localhost zookeeper-3.4.10]# cd conf/

[root@localhost conf]# mv zoo_sample.cfg zoo.cfg

[root@localhost conf]# vim zoo.cfg

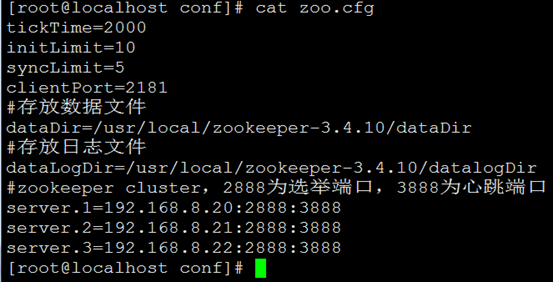

tickTime=2000

initLimit=10

syncLimit=5

clientPort=2181

#存放数据文件

dataDir=/usr/local/zookeeper-3.4.10/dataDir

#存放日志文件

dataLogDir=/usr/local/zookeeper-3.4.10/datalogDir

#zookeeper cluster,2888为选举端口,3888为心跳端口

server.1=192.168.8.20:2888:3888

server.2=192.168.8.21:2888:3888

server.3=192.168.8.22:2888:3888

在我们配置的dataDir指定的目录下面,创建一个myid文件,里面内容为一个数字,用来标识当前主机,conf/zoo.cfg文件中配置的server.X中X为什么数字,则myid文件中就输入这个数字:

[root@localhost local]# echo "1" >/usr/local/zookeeper-3.4.10/dataDir/myid

2)远程复制第一台的zk到另外两台上,并修改myid文件为2和3

[root@localhost conf]# cd /usr/local/

[root@localhost local]# scp -rp zookeeper-3.4.10/ root@192.168.8.21:/usr/local/

[root@localhost local]# scp -rp zookeeper-3.4.10/ root@192.168.8.22:/usr/local/

[root@localhost soft]# echo "2" >/usr/local/zookeeper-3.4.10/dataDir/myid

[root@localhost soft]# echo "3" >/usr/local/zookeeper-3.4.10/dataDir/myid

在ZooKeeper集群的每个结点上,执行启动ZooKeeper服务的脚本,如下所示:

[root@localhost local]# cd zookeeper-3.4.10/bin

[root@localhost bin]# ./zkServer.sh start

ZooKeeper JMX enabled by default

Using config: /usr/local/zookeeper-3.4.10/bin/../conf/zoo.cfg

Starting zookeeper ... STARTED

[root@localhost soft]# cd /usr/local/zookeeper-3.4.10/bin/

[root@localhost bin]# ./zkServer.sh start

ZooKeeper JMX enabled by default

Using config: /usr/local/zookeeper-3.4.10/bin/../conf/zoo.cfg

Starting zookeeper ... STARTED

192.168.8.22:

[root@localhost soft]# cd /usr/local/zookeeper-3.4.10/bin/

[root@localhost bin]# ./zkServer.sh start

ZooKeeper JMX enabled by default

Using config: /usr/local/zookeeper-3.4.10/bin/../conf/zoo.cfg

Starting zookeeper ... STARTED

日志可查询:/usr/local/zookeeper-3.4.10/bin/zookeeper.out

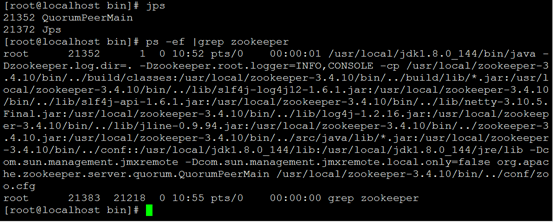

[root@localhost bin]# ps -ef |grep zookeeper

[root@localhost bin]# /usr/local/zookeeper-3.4.10/bin/zkServer.sh stop

可以通过ZooKeeper的脚本来查看启动状态,包括集群中各个结点的角色(或是Leader,或是Follower)

[root@localhost bin]# ./zkServer.sh status

ZooKeeper JMX enabled by default

Using config: /usr/local/zookeeper-3.4.10/bin/../conf/zoo.cfg

[root@localhost bin]# ./zkServer.sh status

ZooKeeper JMX enabled by default

Using config: /usr/local/zookeeper-3.4.10/bin/../conf/zoo.cfg

[root@localhost bin]# ./zkServer.sh status

ZooKeeper JMX enabled by default

Using config: /usr/local/zookeeper-3.4.10/bin/../conf/zoo.cfg

通过上面状态查询结果可见,192.168.8.21是集群的Leader,其余的两个结点是Follower。

另外,可以通过客户端脚本,连接到ZooKeeper集群上。对于客户端来说,ZooKeeper是一个整体,连接到ZooKeeper集群实际上感觉在独享整个集群的服务,所以,你可以在任何一个结点上建立到服务集群的连接。

[root@localhost bin]# ./zkCli.sh -server 192.168.8.20:2181

[zk: 192.168.8.20:2181(CONNECTED) 0] create /test "hello"

[zk: 192.168.8.20:2181(CONNECTED) 1] get /test

ctime = Sun Aug 12 11:10:13 CST 2018

mtime = Sun Aug 12 11:10:13 CST 2018

[root@localhost bin]# ./zkCli.sh -server 192.168.8.21:2181

[zk: 192.168.8.21:2181(CONNECTED) 0] get /test

ctime = Sun Aug 12 11:10:13 CST 2018

mtime = Sun Aug 12 11:10:13 CST 2018

[root@localhost bin]# ./zkCli.sh -server 192.168.8.22:2181

[zk: 192.168.8.22:2181(CONNECTED) 0] get /test

ctime = Sun Aug 12 11:10:13 CST 2018

mtime = Sun Aug 12 11:10:13 CST 2018

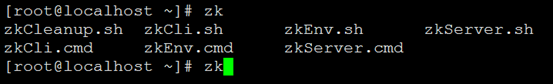

添加zookeeper环境变量/etc/profile内容如下

export PATH=/usr/local/zookeeper-3.4.10/bin:$PATH

至此,Zookeeper集群搭建完毕。

若文章图片、下载链接等信息出错,请在评论区留言反馈,博主将第一时间更新!如本文“对您有用”,欢迎随意打赏,谢谢!

亲测,写的不错,感谢博主